Celem projektu H.264/AVC jest stworzenie standardu, który może zapewnić dobrą jakość wideo przy znacznie niższej przepływności niż poprzednie standardy (tj. o połowę niższą niż MPEG-2, H.263 lub MPEG- lub więcej). Niski). 4 część 2), bez zwiększania złożoności projektu, tak aby był niepraktyczny lub zbyt kosztowny w realizacji. Kolejnym celem jest zapewnienie wystarczającej elastyczności, aby umożliwić stosowanie standardu w różnych aplikacjach w różnych sieciach i systemach, w tym w przypadku niskich i wysokich przepływności, wideo w niskiej i wysokiej rozdzielczości, nadawania, przechowywania DVD, sieci pakietowej RTP/IP i multimedialnego systemu telefonicznego ITU-T. Standard H.264 można uznać za „rodzinę standardów” złożoną z wielu różnych plików konfiguracyjnych. Konkretny dekoder dekoduje co najmniej jeden, ale niekoniecznie wszystkie profile. Specyfikacja dekodera opisuje, które pliki konfiguracyjne mogą być dekodowane. H.264 jest zwykle używany do kompresji stratnej, chociaż możliwe jest również tworzenie prawdziwie bezstratnych regionów kodowania w obrazach kodowanych stratnie lub do obsługi rzadkich przypadków użycia, w których całe kodowanie jest bezstratne.

H.264 został opracowany przez ITU-T Video Coding Expert Group (VCEG) wraz z ISO/IEC JTC1 Moving Picture Experts Group (MPEG). Partnerstwo projektu nosi nazwę Joint Video Team (JVT). Standard ITU-T H.264 i standard ISO/IEC MPEG-4 AVC (formalnie ISO/IEC 14496-10-MPEG-4 Part 10, Advanced Video Coding) są wspólnie utrzymywane, dzięki czemu mają tę samą zawartość techniczną. W maju 2003 r. zakończono prace nad ostatecznym opracowaniem pierwszej edycji normy, a kolejne edycje zawierały różne rozszerzenia jej funkcji. High Efficiency Video Coding (HEVC), czyli H.265 i MPEG-H Part 2, są następcami H.264/MPEG-4 AVC opracowanego przez tę samą organizację, a wcześniejsze standardy są nadal powszechnie stosowane.

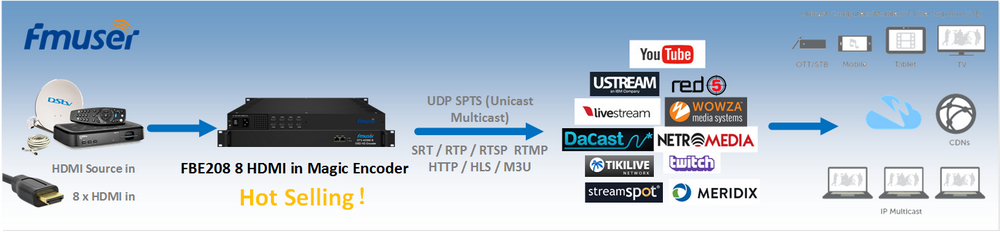

Najbardziej znany H.264 jest prawdopodobnie jednym ze standardów kodowania wideo dla dysków Blu-ray; wszystkie odtwarzacze płyt Blu-ray muszą być w stanie dekodować H.264. Jest również szeroko stosowany do przesyłania strumieniowego zasobów internetowych, takich jak filmy z Vimeo, YouTube i iTunes Store, oprogramowania sieciowego, takiego jak Adobe Flash Player i Microsoft Silverlight, oraz różnych transmisji HDTV naziemnych (ATSC, ISDB-T, DVB)-T lub DVB-T2), kablowych (DVB-C) i satelitarnych (DVB-S i DVB-S2).

H.264 jest chroniony patentami należącymi do wszystkich stron. Licencje obejmujące większość (ale nie wszystkie) patentów niezbędnych dla H.264 są zarządzane przez pulę patentów MPEG LA. 3 Komercyjne wykorzystanie opatentowanej technologii H.264 wymaga uiszczania opłat licencyjnych na rzecz MPEG LA i innych właścicieli patentów. MPEG LA umożliwia bezpłatne korzystanie z technologii H.264 w celu zapewnienia użytkownikom końcowym darmowego strumieniowego przesyłania wideo w Internecie, a firma Cisco Systems płaci tantiemy firmie MPEG LA w imieniu użytkowników plików binarnych kodera H.264 o otwartym kodzie źródłowym.

1. Nazewnictwo

Nazwa H.264 jest zgodna z konwencją nazewnictwa ITU-T, która jest członkiem serii H.26x standardów kodowania wideo VCEG; nazwa MPEG-4 AVC jest związana z konwencją nazewnictwa w ISO/IEC MPEG, gdzie standardem jest ISO/IEC 14496 część 10, ISO/IEC 14496 to zestaw standardów o nazwie MPEG-4. Standard został opracowany wspólnie w partnerstwie między VCEG i MPEG, a projekt VCEG o nazwie H.26L był wcześniej prowadzony w ITU-T. Dlatego nazwy takie jak H.264/AVC, AVC/H.264, H.264/MPEG-4AVC lub MPEG-4/H.264 AVC są często używane w odniesieniu do standardu w celu podkreślenia wspólnego dziedzictwa. Czasami jest również nazywany „kodek JVT”, należy odnieść się do organizacji Joint Video Team (JVT), która go opracowała. (Tego rodzaju partnerstwo i wiele nazw nie są rzadkością. Na przykład standard kompresji wideo o nazwie MPEG-2 również wywodzi się z partnerstwa między MPEG i ITU-T, gdzie wideo MPEG-2 jest nazywane przez społeczność ITU-T H.262. 4) Niektóre programy (takie jak VLC media player) wewnętrznie identyfikują ten standard jako AVC1.

2. Historia

Na początku 1998 roku grupa ekspertów ds. kodowania wideo (VCEG-ITU-T SG16 Q.6) ogłosiła zaproszenie do składania wniosków dotyczących projektu o nazwie H.26L, którego celem było podwojenie wydajności kodowania (co oznacza zmniejszenie wymaganej przepływności o połowę). VCEG jest kierowany przez Gary'ego Sullivana (Microsoft, dawniej PictureTel, USA). Pierwszy projekt nowego standardu został przyjęty w sierpniu 1999 roku. W 2000 roku współprzewodniczącym VCEG został Thomas Wiegand (Instytut Heinricha Hertza, Niemcy).

W grudniu 2001 roku VCEG i Moving Picture Experts Group (MPEG-ISO / IEC JTC 1 / SC 29 / WG 11) utworzyły Joint Video Group (JVT), a jej statut sfinalizował standard kodowania wideo. [5] Specyfikacja została formalnie zatwierdzona w marcu 2003 r. JVT kierowali Gary Sullivan, Thomas Wiegand i Ajay Luthra (Motorola, USA, później Arris, USA). W czerwcu 2004 r. sfinalizowano projekt Fidelity Scope Extension (FRExt). Od stycznia 2005 do listopada 2007, JVT pracuje nad rozszerzeniem H.264/AVC do skalowalności poprzez załącznik (G) o nazwie Scalable Video Coding (SVC). Zespół zarządzający JVT powiększył się o Jensa-Rainera Ohma (Uniwersytet w Akwizgranie, Niemcy). Od lipca 2006 do listopada 2009 firma JVT uruchomiła kodowanie wideo Multi-Video (MVC), które jest rozszerzeniem H.264/AVC na telewizję ogólnodostępną i telewizję 3D. Ta praca obejmuje opracowanie dwóch nowych profili standardowych: Multiview High Profile i Stereo High Profile.

Standaryzacja pierwszej wersji H.264/AVC została zakończona w maju 2003 roku. W ramach pierwszego projektu rozszerzenia oryginalnego standardu, JVT opracował następnie tzw. Fidelity Range Extensions (FRExt). Te rozszerzenia zapewniają wyższą jakość kodowania wideo dzięki obsłudze większej dokładności bitowej próbkowania i informacji o kolorze o wyższej rozdzielczości, w tym tak zwanej struktury próbkowania Y'CbCr 4:2:2 (= YUV 4:2:2) i Y'CbCr 4:4: , wydajne bezstratne kodowanie między obrazami oraz obsługa dodatkowych przestrzeni kolorów . Prace projektowe Fidelity Range Extensions zakończono w lipcu 4 r., a prace redakcyjne zakończono we wrześniu 4 r.

Niedawne dalsze rozszerzenie standardu obejmuje dodanie pięciu innych nowych profili [który? ] Używany głównie do zastosowań profesjonalnych, dodając obsługę rozszerzonej przestrzeni gamy kolorów, definiując dodatkowe wskaźniki proporcji, definiując dwa inne typy „dodatkowych informacji o ulepszeniach” (wskazówki po filtrze i mapowanie tonów) oraz odrzucając poprzedni plik konfiguracyjny FRExt One (wysoki profil 4: 4: 4), opinie branżowe [przez kogo? ] Instrukcje powinny być zaprojektowane inaczej.

Kolejną ważną funkcją dodaną do standardu jest Scalable Video Coding (SVC). W załączniku G do H.264/AVC określono, że SVC umożliwia konstruowanie strumieni bitów zawierających podstrumienie bitów, które również są zgodne ze standardem, w tym jeden taki strumień bitów zwany „warstwą bazową”, który może być dekodowany przez kodek H.264/AVC obsługujący SVC. Dla czasowej skalowalności strumienia bitów (tj. istnieją podstrumienie bitów z mniejszą czasową częstotliwością próbkowania niż główny strumień bitów), kompletne jednostki dostępowe są usuwane ze strumienia bitów, gdy ten podstrumień bitów jest wyznaczany. W tym przypadku składnia wysokiego poziomu i obrazy odniesienia między predykcjami w strumieniu bitów są odpowiednio konstruowane. Z drugiej strony, dla przestrzennej i jakościowej skalowalności strumienia bitów (tj. istnieją podstrumienie bitów o niższej rozdzielczości/jakości przestrzennej niż główny strumień bitów), usuń NAL ze strumienia bitów podczas wyprowadzania podstrumienia bitów (warstwa abstrakcji sieci). . W tym przypadku predykcja międzywarstwowa (tj. przewidywanie sygnału o wyższej rozdzielczości przestrzennej/jakości na podstawie danych sygnału o niższej rozdzielczości przestrzennej/jakości) jest ogólnie stosowana do wydajnego kodowania. Skalowalne rozszerzenie do kodowania wideo zostało ukończone w listopadzie 2007 roku.

Następną ważną funkcją dodaną do standardu jest Multi-View Video Coding (MVC). W załączniku H do H.264/AVC określono, że MVC umożliwia budowę strumienia bitów reprezentującego więcej niż jeden widok sceny wideo. Ważnym przykładem tej funkcji jest stereoskopowe kodowanie wideo 3D. W pracy MVC opracowano dwa profile: Multiview High Profile obsługuje dowolną liczbę widoków, a Stereo High Profile jest specjalnie zaprojektowany do stereofonicznego wideo z dwoma widokami. Rozszerzenie kodowania wideo Multiview zostało ukończone w listopadzie 2009 roku.

3. Aplikacja

Format wideo H.264 ma bardzo szeroki zakres zastosowań, obejmujący wszystkie formy cyfrowo skompresowanego wideo, od aplikacji do przesyłania strumieniowego w Internecie o niskiej przepływności po transmisje HDTV i aplikacje do prawie bezstratnego kodowania filmów cyfrowych. Używając H.264, w porównaniu z MPEG-2 Part 2, przepływność można zaoszczędzić o 50% lub więcej. Podaje się na przykład, że jakość cyfrowej telewizji satelitarnej zapewnianej przez H.264 jest taka sama jak w obecnej implementacji MPEG-2, z przepływnością mniejszą niż połowa. Obecna szybkość implementacji MPEG-2 wynosi około 3.5 Mbit/s, podczas gdy H.264 to tylko 1.5 Mbit. /S. [23] Sony twierdzi, że tryb nagrywania 9 Mbit/s AVC odpowiada jakości obrazu formatowi HDV, który wykorzystuje około 18-25 Mbit/s.

Aby zapewnić kompatybilność i bezproblemową adaptację H.264/AVC, wiele organizacji normalizacyjnych zmodyfikowało lub dodało swoje standardy związane z wideo, aby użytkownicy tych standardów mogli używać H.264/AVC. Zarówno format Blu-ray Disc, jak i obecnie wycofany format HD DVD wykorzystują H.264 / AVC High Profile jako jeden z trzech obowiązkowych formatów kompresji wideo. Projekt Digital Video Broadcasting Project (DVB) zatwierdził użycie H.264/AVC w telewizji pod koniec 2004 roku.

Amerykański organ ds. Standardów Advanced Television System Committee (ATSC) zatwierdził H.264 / AVC dla telewizji nadawczej w lipcu 2008 r., Chociaż standard ten nie był jeszcze używany w stałych transmisjach ATSC w Stanach Zjednoczonych. [25] [26] Jest również zatwierdzony dla najnowszego standardu ATSC-M/H (mobile/handheld), wykorzystując części AVC i SVC H.264.

Rynek CCTV (telewizja przemysłowa) i nadzoru wideo włączył tę technologię do wielu produktów. Wiele popularnych lustrzanek cyfrowych wykorzystuje wideo H.264 zawarte w kontenerze QuickTime MOV jako natywny format nagrywania.

4. Format pochodny

AVCHD to format nagrywania w wysokiej rozdzielczości opracowany przez firmy Sony i Panasonic przy użyciu H.264 (zgodny z H.264, ale z dodatkowymi funkcjami i ograniczeniami specyficznymi dla aplikacji).

AVC-Intra to format kompresji wewnątrzklatkowej opracowany przez firmę Panasonic.

XAVC to format nagrywania opracowany przez firmę Sony i wykorzystuje poziom 5.2 standardu H.264/MPEG-4 AVC, który jest najwyższym poziomem obsługiwanym przez ten standard wideo. [28] [29] XAVC obsługuje rozdzielczości 4K (4096×2160 i 3840×2160) z prędkością do 60 klatek na sekundę (fps). [28] [29] Firma Sony ogłosiła, że wśród aparatów obsługujących format XAVC znajdują się dwie kamery CineAlta — Sony PMW-F55 i Sony PMW-F5. [30] Sony PMW-F55 może nagrywać w formacie XAVC, rozdzielczość 4K to 30 kl./s, prędkość 300 Mbit/s, rozdzielczość 2K, 30 kl./s, 100 Mbit/s. [31] XAVC może nagrywać w rozdzielczości 4K przy 60 kl./s i przeprowadzać podpróbkowanie chrominancji 4:2:2 z szybkością 600 Mbit/s.

5. cechy

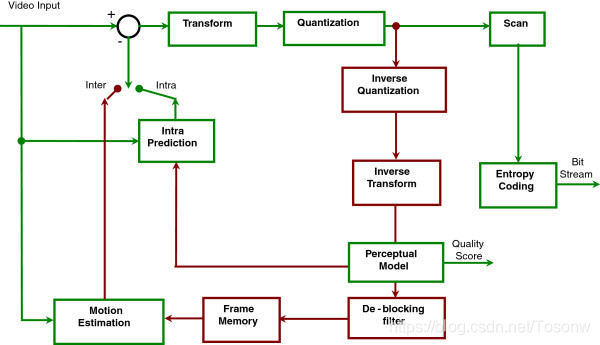

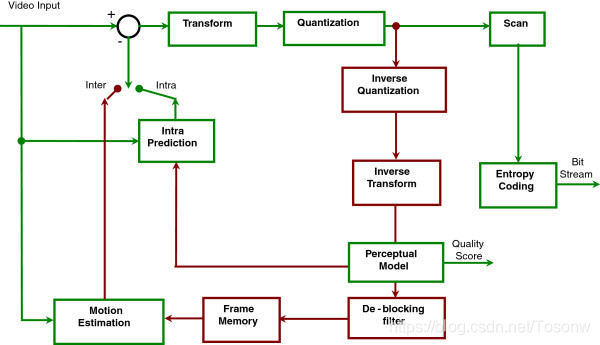

Schemat blokowy H.264

H.264 / AVC / MPEG-4 Part 10 zawiera wiele nowych funkcji, które umożliwiają bardziej wydajną kompresję wideo niż stary standard i zapewniają większą elastyczność aplikacji w różnych środowiskach sieciowych. W szczególności niektóre z tych kluczowych funkcji obejmują:

1) Wieloobrazowe przewidywanie między obrazami obejmuje następujące funkcje:

Wykorzystaj wcześniej zakodowane obrazy jako odniesienia w bardziej elastyczny sposób niż poprzednie standardy, umożliwiając w niektórych przypadkach użycie do 16 ramek odniesienia (lub 32 pól odniesienia w przypadku kodowania z przeplotem). W profilach, które obsługują ramki inne niż IDR, większość poziomów określa, że powinno być wystarczające buforowanie, aby umożliwić co najmniej 4 lub 5 ramek odniesienia przy maksymalnej rozdzielczości. Kontrastuje to z istniejącymi standardami, które zwykle mają limit 1; lub, w przypadku tradycyjnych „obrazów B” (klatki B), dwa. Ta specjalna funkcja zwykle pozwala na niewielką poprawę szybkości transmisji bitów i jakości w większości scenariuszy. [Potrzeba cytatu] Jednak w niektórych typach scen, takich jak sceny z powtarzającymi się akcjami lub przełączaniem scen tam iz powrotem lub niezakrytymi obszarami tła, pozwala to znacznie zmniejszyć przepływność przy zachowaniu przejrzystości.

Kompensacja ruchu o zmiennym rozmiarze bloku (VBSMC), rozmiar bloku to 16 × 16, tak mały jak 4 × 4, który może realizować precyzyjną segmentację ruchomego obszaru. Obsługiwane rozmiary bloków przewidywania luminancji obejmują 16×16, 16×8, 8×16, 8×8, 8×4, 4×8 i 4×4, z których wiele można wykorzystać razem w jednym makrobloku. Zgodnie z używanym podpróbkowaniem chrominancji rozmiar bloku predykcji chrominancji jest odpowiednio mniejszy.

W przypadku makrobloku B złożonego z 16 partycji 4×4, każdy makroblok może wykorzystywać wiele wektorów ruchu (jeden lub dwa dla każdej partycji), maksymalnie 32. Wektor ruchu każdego obszaru partycji 8×8 lub większego może wskazywać inny obraz odniesienia.

W ramkach B można stosować makrobloki dowolnego typu, w tym makrobloki I, co skutkuje wydajniejszym kodowaniem przy użyciu ramek B. Ta cecha jest widoczna w MPEG-4 ASP.

Filtrowanie po sześciu dotknięciach używane do przewidywania próbki luminancji połowy piksela w celu uzyskania wyraźniejszej kompensacji ruchu subpikseli. Ruch ćwiartki piksela jest uzyskiwany poprzez interpolację liniową wartości półkoloru w celu zaoszczędzenia mocy obliczeniowej.

Precyzja ćwierć piksela stosowana do kompensacji ruchu może dokładnie opisać przemieszczenie ruchomego obszaru. W przypadku chrominancji rozdzielczość jest zwykle zmniejszana o połowę w kierunku pionowym i poziomym (patrz 4:2:0), więc kompensacja ruchu chrominancji wykorzystuje jedną ósmą jednostki siatki chroma piksela.

Ważona predykcja umożliwia koderowi określenie zastosowania skalowania i przesunięcia podczas wykonywania kompensacji ruchu i zapewnia znaczną poprawę wydajności w szczególnych sytuacjach, takich jak przejścia do zanikania i zanikania, pojawiania się i zanikania oraz zanikania i zanikania. Obejmuje to niejawną ważoną predykcję ramek B i jawną ważoną predykcję ramek P.

Predykcja przestrzenna dla krawędzi sąsiednich bloków dla kodowania „wewnątrz” zamiast przewidywania „DC” znalezionego w MPEG-2 część 2 i przewidywania współczynnika transformacji w H.263v2 i MPEG-4 część 2:

Obejmuje to bloki przewidywania luminancji o rozmiarach 16×16, 8×8 i 4×4 (gdzie tylko jeden typ może być użyty w każdym makrobloku).

2) Bezstratne funkcje kodowania makrobloków obejmują:

Bezstratny „makroblok PCM” reprezentuje tryb, który bezpośrednio reprezentuje próbki danych wideo, [34] umożliwia doskonałą reprezentację określonego obszaru i pozwala na ścisłe ograniczenie ilości kodowanych danych dla każdego makrobloku.

Udoskonalony bezstratny tryb reprezentacji makrobloków pozwala na doskonałą reprezentację określonego obszaru przy użyciu znacznie mniejszej liczby bitów niż w trybie PCM.

Elastyczne funkcje kodowania wideo z przeplotem, w tym:

Adaptacyjne kodowanie ramki-pola makrobloków (MBAFF) wykorzystuje strukturę par makrobloków dla obrazu zakodowanego jako ramka, umożliwiając makrobloki 16 × 16 w trybie polowym (w porównaniu z MPEG-2, gdzie przetwarzanie w trybie polowym jest realizowane w kodowaniu obrazu jako ramka powoduje przetwarzanie półmakrobloków 16 × 8).

Adaptacyjne kodowanie ramek i pól obrazu (PAFF lub PicAFF) umożliwia łączenie dowolnie wybranych obrazów i kodowanie ich jako kompletnej klatki, w której dwa pola są łączone do kodowania lub jako pojedyncze pole.

Nowe funkcje projektowania konwersji, w tym:

Dokładnie dopasowująca się przestrzenna transformacja bloku liczb całkowitych 4 × 4, umożliwiająca dokładne rozmieszczenie sygnałów resztkowych, prawie bez „dzwonienia” powszechnego w poprzednich projektach kodeków. Ten projekt jest podobny w koncepcji do dobrze znanej dyskretnej transformaty kosinusowej (DCT), która została wprowadzona w 1974 roku przez N. Ahmeda, T. Natarajana i KR Rao i jest odniesieniem 1 w dyskretnej transformacji kosinusowej. Jest jednak uproszczony i zapewnia precyzyjnie określone dekodowanie.

Dokładne dopasowanie transformacji bloków przestrzennych liczb całkowitych 8×8, umożliwiając bardziej wydajną kompresję wysoce skorelowanych regionów niż transformacje 4×4. Projekt jest podobny w koncepcji do dobrze znanego DCT, ale jest uproszczony i zapewnia precyzyjnie określone dekodowanie.

Adaptacyjny wybór enkodera między rozmiarami bloków transformacji 4 × 4 i 8 × 8 dla operacji transformacji liczb całkowitych.

Wtórna transformata Hadamarda jest wykonywana na współczynnikach „DC” głównej transformacji przestrzennej stosowanej do współczynników DC chrominancji (aw szczególnym przypadku także luminancji), aby uzyskać jeszcze większą kompresję w obszarze gładkim.

3) Projekt ilościowy obejmuje:

Logarytmiczna kontrola wielkości kroku, prostsze zarządzanie przepływnością i uproszczone skalowanie odwrotnej kwantyzacji przez koder

Dostosowana do częstotliwości macierz skalowania kwantyzacji wybrana przez koder jest używana do optymalizacji kwantyzacji na podstawie percepcji

Filtr odblokowujący pętle pomaga zapobiegać efektowi blokowemu, typowemu dla innych technologii kompresji obrazu opartych na DCT, w celu uzyskania lepszego wyglądu i wydajności kompresji

4) Projekt kodowania entropijnego obejmuje:

Dostosowujące się do kontekstu binarne kodowanie arytmetyczne (CABAC), algorytm bezstratnej kompresji elementów składni w strumieniu wideo, który zna prawdopodobieństwo wystąpienia elementów składni w danym kontekście. CABAC kompresuje dane wydajniej niż CAVLC, ale wymaga więcej przetwarzania do dekodowania.

Kontekstowe kodowanie o zmiennej długości (CAVLC), które jest alternatywą o niższej złożoności dla CABAC używanego do kodowania skwantowanych wartości współczynników transformacji. Chociaż złożoność jest mniejsza niż CABAC, CAVLC jest bardziej wyrafinowany i skuteczniejszy niż metody powszechnie stosowane do kodowania współczynników w innych istniejących projektach.

Powszechna prosta i wysoce ustrukturyzowana technika kodowania o zmiennej długości (VLC) używana dla wielu elementów składni, które nie są kodowane przez CABAC lub CAVLC, nazywana jest wykładniczym kodowaniem Golomba (lub Exp-Golomb).

5) Funkcje odzyskiwania strat obejmują:

Definicja warstwy abstrakcji sieci (NAL) umożliwia stosowanie tej samej składni wideo w wielu środowiskach sieciowych. Bardzo podstawową koncepcją projektową H.264 jest generowanie niezależnych pakietów danych w celu usunięcia zduplikowanych nagłówków, takich jak kod rozszerzenia nagłówka MPEG-4 (HEC). Osiąga się to poprzez oddzielenie informacji związanych z wieloma wycinkami ze strumienia mediów. Kombinacja parametrów zaawansowanych nazywana jest zestawem parametrów. [35] Specyfikacja H.264 obejmuje dwa rodzaje zestawów parametrów: zestaw parametrów sekwencji (SPS) i zestaw parametrów obrazu (PPS). Efektywny zestaw parametrów sekwencji pozostaje niezmieniony w całej zakodowanej sekwencji wideo, a efektywny zestaw parametrów obrazu pozostaje niezmieniony w zakodowanym obrazie. Struktura zestawu parametrów sekwencji i obrazu zawiera informacje, takie jak rozmiar obrazu, przyjęty opcjonalny tryb kodowania i mapowanie grupy makrobloków na plasterki.

Elastyczne porządkowanie makrobloków (FMO), znane również jako grupa wycinków, oraz arbitralne porządkowanie wycinków (ASO) to technika używana do rekonstrukcji uporządkowania reprezentacji podstawowych regionów (makrobloków) na obrazie. Ogólnie uważane za funkcje odporności na błędy/straty, FMO i ASO mogą być również wykorzystywane do innych celów.

Partycjonowanie danych (DP), funkcja, która może dzielić ważniejsze i mniej ważne elementy składni na różne pakiety danych, może stosować nierówną ochronę przed błędami (UEP) i inne rodzaje ulepszeń odporności na błędy/utraty.

Nadmiarowy wycinek (RS), funkcja odporności na błędy/utraty, która umożliwia koderowi wysłanie dodatkowej reprezentacji obszaru obrazu (zwykle z niższą wiernością), której można użyć, jeśli główna reprezentacja zostanie uszkodzona lub utracona.

Numer klatki, pozwalający na tworzenie funkcji „podsekwencji”, osiągnięcie skalowalności czasowej poprzez opcjonalne włączanie dodatkowych obrazów między inne obrazy oraz wykrywanie i ukrywanie utraty całego obrazu, która może być spowodowana utratą pakietu sieciowego lub kanału Wystąpił błąd.

Przełączanie wycinków, zwanych wycinkami SP i SI, umożliwia koderowi poinstruowanie dekodera, aby przeskoczył do trwającego strumienia wideo w celach takich jak przełączanie przepływności strumienia wideo i operacje w trybie sztuczki. Kiedy dekoder wykorzystuje funkcję SP/SI do przeskoczenia do środka strumienia wideo, może uzyskać dokładne dopasowanie do zdekodowanego obrazu w tej pozycji w strumieniu wideo, pomimo użycia innego obrazu lub braku obrazu jako poprzedniego odniesienia. przełącznik.

Prosty automatyczny proces stosowany w celu zapobiegania przypadkowej symulacji kodu startowego, który jest specjalną sekwencją bitów w zakodowanych danych, umożliwia swobodny dostęp do strumienia bitów i przywraca wyrównanie bajtów w systemach, w których synchronizacja bajtów może zostać utracona.

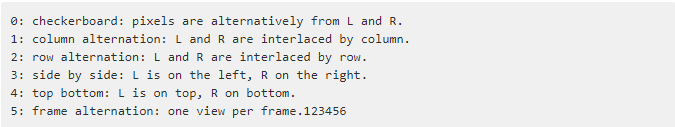

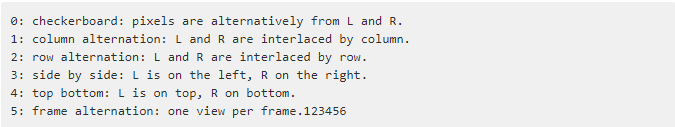

Dodatkowe informacje o ulepszeniu (SEI) i informacje o użyteczności wideo (VUI) to dodatkowe informacje, które można wstawić do strumienia bitów w celu ulepszenia wideo do różnych celów. [Potrzebne wyjaśnienie] SEI FPA (ang. Frame Encapsulation Arrangement) zawiera układ 3D komunikatów:

Obraz pomocniczy, który można wykorzystać do syntezy alfa i innych celów.

Obsługuje monochromatyczne (4:0:0), 4:2:0, 4:2:2 i 4:4:4 podpróbkowanie chrominancji (w zależności od wybranego profilu).

Obsługuje dokładność bitową próbkowania w zakresie od 8 do 14 bitów na próbkę (w zależności od wybranego profilu).

Możliwość zakodowania każdej płaszczyzny koloru na różne obrazy z własną strukturą plasterków, trybem makrobloków, wektorem ruchu itp., co pozwala na użycie prostej struktury równoległej do zaprojektowania kodera (obsługiwane są tylko trzy pliki konfiguracyjne obsługujące format 4:4:4).

Zliczanie sekwencji obrazów służy do zachowania kolejności obrazów i charakterystyki wartości próbek w zdekodowanym obrazie odizolowanym od informacji o taktowaniu, umożliwiając systemowi oddzielne przenoszenie i sterowanie/zmianę informacji o taktowaniu bez wpływu na zawartość zdekodowanego obrazu.

Te technologie i kilka innych technologii pomagają H.264 działać lepiej niż jakikolwiek poprzedni standard w różnych środowiskach aplikacji w różnych sytuacjach. H.264 generalnie działa lepiej niż wideo MPEG-2 — zwykle ta sama jakość przy przepływności o połowę mniejszej lub niższej, zwłaszcza przy dużych przepływnościach i wysokich rozdzielczościach.

Podobnie jak inne standardy wideo ISO/IEC MPEG, H.264/AVC ma referencyjną implementację oprogramowania, którą można pobrać bezpłatnie. Jego głównym celem jest przedstawienie przykładów funkcji H.264/AVC, a nie użyteczna aplikacja sama w sobie. Grupa Motion Picture Experts Group wykonuje również pewne prace projektowe dotyczące sprzętu referencyjnego. Powyżej przedstawiono wszystkie funkcje H.264/AVC, obejmujące wszystkie pliki konfiguracyjne H.264. Profil kodeka to zestaw cech kodera-dekodera, który jest identyfikowany jako spełniający określony zestaw specyfikacji dla zamierzonego zastosowania. Oznacza to, że niektóre pliki konfiguracyjne nie obsługują wielu wymienionych funkcji. Różne pliki konfiguracyjne H.264/AVC zostaną omówione w następnej sekcji.

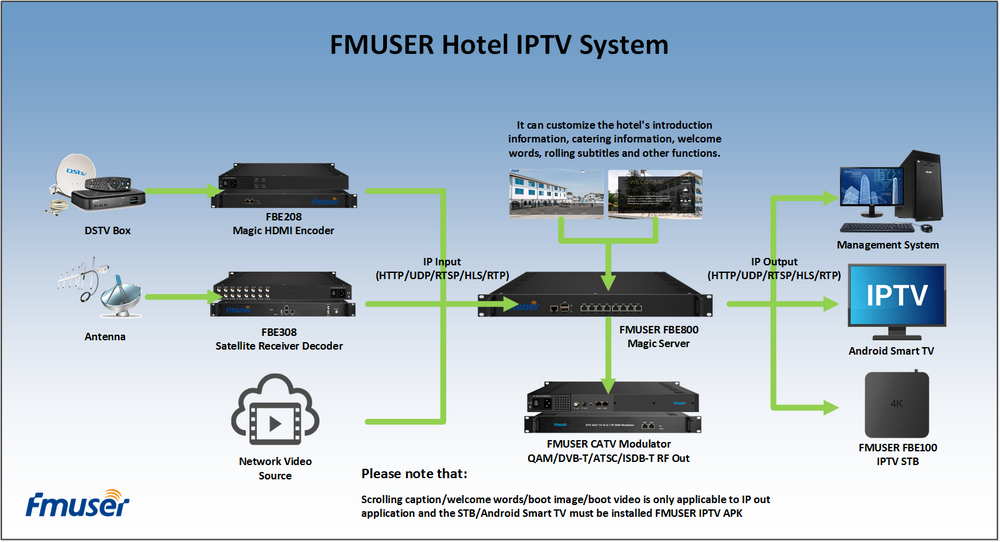

Nasze inne produkty: